Previsão numérica do tempo

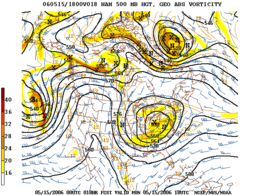

Previsão numérica do tempo Exemplo de saída de mapa com contornos pretos de isohipos da altura da pressão geopotencial de 500 hPa por um modelo de predição numérica

Exemplo de saída de mapa com contornos pretos de isohipos da altura da pressão geopotencial de 500 hPa por um modelo de predição numérica

| Usar | Previsão do tempo |

|---|

A previsão numérica do tempo (NWP) é uma aplicação da meteorologia e do computador . Baseia-se na escolha de equações matemáticas que oferecem uma boa aproximação do comportamento da atmosfera real. Essas equações são então resolvidas, usando um computador , para obter uma simulação acelerada dos estados futuros da atmosfera. O software que implementa esta simulação é chamado de modelo numérico de previsão do tempo .

Histórico

A ideia de usar modelos digitais para prever o tempo que virá foi um importante avanço na história da meteorologia . Em 1904, Vilhelm Bjerknes foi o primeiro a propor que a previsão do comportamento da atmosfera pudesse ser tratada como um problema de física matemática colocado de acordo com as condições iniciais.

A disciplina de previsão numérica do tempo foi fundada em 1922 com a publicação do livro Weather Prediction by Numerical Process , do matemático britânico Lewis Fry Richardson . Duas décadas antes da invenção do computador, Richardson imaginou ter um exército de computadores humanos resolvendo numericamente as equações desenvolvidas por Bjerknes. No entanto, ele falhou devido à complexidade computacional e instabilidade numérica causada por erros intrínsecos nos dados.

Em 1928, Courant , Friedrichs e Lewy publicou um artigo sobre as restrições da digitalização de dados e equações de modelo numérico para evitar essas instabilidades. A visão pioneira de Richardson começou a dar frutos em 1950, quando Charney , Fjørtoft (in) e von Neumann conseguiram o primeiro NWP em um computador, o ENIAC , usando um modelo barótropo simples. A primeira previsão operacional data de 1954 pelo Instituto Sueco de Meteorologia e Hidrologia, graças ao trabalho da equipe de Carl-Gustaf Rossby . Os primeiros programas operacionais de previsão numérica mais complexos foram desenvolvidos no início dos anos 1960, usando uma atmosfera baroclínica e de vários níveis . A evolução foi inicialmente mais lenta para análises objetivas do que para previsões devido à falta de dados sobre oceanos e áreas desérticas, mas a situação mudou com a integração de dados de satélites meteorológicos desde a década de 1990.

Diante de uma forte demanda por previsões meteorológicas em diversos campos de atividade, a disciplina continuou a se desenvolver desde então, apoiada no aumento da capacidade de computação e alimentada por enormes avanços teóricos nos métodos numéricos e na meteorologia.

Usos

- Em meteorologia operacional, o NWP é usado para fazer previsões cujos resultados numéricos brutos passarão por várias formas de pós-processamento para torná-los utilizáveis. Os resultados serão processados por outro software ou interpretados por meteorologistas para atender às necessidades específicas do usuário. Isso inclui previsão do tempo público e aplicações em um grande número de campos de atividade, como transporte , agricultura , mitigação de desastres, etc.

- Os resultados da previsão numérica são usados para conduzir outros modelos especializados. Estes podem ser, por exemplo, modelos de dispersão e trajetória de poluentes atmosféricos, ou modelos de química atmosférica para a previsão da qualidade do ar (previsão de smog , em particular).

- O PNT pode ser usado, em pesquisa , para fazer estudos de caso "isoladamente", para estudar uma faceta ou um comportamento particular da atmosfera ou para testar melhorias no modelo de acordo com casos teóricos ou práticos de que tenhamos conhecimento. resultados. O modelo PNT torna-se assim um laboratório virtual para estudar a atmosfera e melhorar as previsões.

- Os modelos NWP também podem ser usados para previsão do clima . Estamos, então, interessados no comportamento médio da previsão em um longo período e não mais em prever eventos específicos. Ao alterar aspectos da previsão, como a taxa de aumento do dióxido de carbono, os modelos de previsão do clima ajudam a formular cenários sobre as consequências das mudanças climáticas. O estudo desses cenários ajuda a orientar o público e os tomadores de decisão frente ao aquecimento global .

Abordagem matemática

Em física e engenharia, a abordagem clássica para obter equações com valor preditivo é resolver uma ou mais equações diferenciais contendo a variável de tempo . Nos casos mais convenientes, a solução expressa as variáveis a serem previstas em função do tempo e das condições iniciais (os valores das variáveis no momento escolhido para o início da previsão). Então, é suficiente alimentar esta equação com os valores numéricos necessários para obter a chamada solução exata . O oscilador harmônico é um exemplo de problema clássico que se adapta bem a essa abordagem.

O problema do comportamento futuro da atmosfera é muito mais complexo e tem solução exata apenas em alguns subconjuntos teóricos muito restritos. Para resolver as equações de NWP no mundo real, é necessário usar os métodos de análise numérica . Esses métodos permitem reformular as equações do comportamento atmosférico de forma a poder resolvê-las por numerosas iterações de cálculos numéricos brutos. Desta forma, o estado da atmosfera é progredido no modelo desde um ponto de partida até o intervalo de previsão desejado.

A desvantagem desses métodos numéricos é que eles exigem uma aproximação da continuidade de tempo e espaço em uma grade de computação; a simulação torna-se assim descontínua no tempo e no espaço. Os resultados, visualizados em sua grade de cálculo, têm uma aparência “pixelizada”, semelhante a uma imagem digital. Da mesma forma, o tempo não é mais uma variável contínua, com os cálculos pulando de uma etapa de tempo para a próxima.

Exemplo típico: uma das configurações operacionais do modelo GEM da Environment Canada (em 2005 ) divide o espaço da América do Norte e as águas adjacentes em ladrilhos quadrados de 15 km. O tamanho desses ladrilhos define a resolução horizontal ou tamanho da malha do modelo. Além disso, o modelo representa a dimensão vertical da atmosfera, dividindo-a em 58 níveis. E, finalmente, cada rodada de cálculos do modelo avança a previsão em 450 segundos. O intervalo de tempo do modelo entre as rodadas de cálculos é chamado de intervalo de tempo .

Como regra geral, é desejável garantir que o padrão tenha a malha mais fina possível. Isso aumenta o realismo do modelo e minimiza o acúmulo de pequenos erros de cálculo inerentes aos métodos de análise numérica. Além disso, para uma determinada resolução, existe um intervalo de tempo máximo, denominado condição Current-Friedrich-Levy (ou condição CFL), que não deve ser ultrapassado para preservar a estabilidade e o realismo dos resultados numéricos.

Parametrização de sub-malha

Para obter uma boa previsão, também é necessário levar em consideração fenômenos menores que a resolução do modelo (os chamados fenômenos de sub-malhas ). Por exemplo, uma tempestade é consideravelmente menor do que a malha da maioria dos modelos em escala real; considerados isoladamente, poderíamos nos dar ao luxo de negligenciá-lo no contexto de uma previsão à escala de um país ou continente. Mas uma área de trovoada, incluindo muitas trovoadas numa grande área geográfica, terá um impacto significativo no curso do evento que é objecto da previsão, através da produção de uma quantidade apreciável de chuva e do seu efeito na previsão. equilíbrio da atmosfera. Mais fundamentalmente ainda: deixado por si mesmo, o modelo poderia criar tempestades cujo tamanho horizontal seria igual à malha do modelo, o que é completamente irreal e distorceria brutalmente a evolução da previsão. Devemos, portanto, dar às tempestades uma existência implícita dentro do modelo, a fim de dissipar a energia convectiva, respeitando as considerações de escala.

A representação da influência de médio a grande escala de fenômenos de pequena escala é chamada de parametrização . Os fenômenos de submalha mais comumente parametrizados por designers de modelo são:

- A convecção atmosférica vertical (que inclui tempestades)

- A física da nuvem ( condensação , coleta e colisão de gotas, efeito Bergeron , mudanças de estágio , etc.)

- Efeitos radiativos atmosféricos (radiação de calor)

- A interface superfície-ar:

- Troca de calor e umidade entre a superfície e a atmosfera

- Atrito e turbulência perto do solo

- O efeito das montanhas e terrenos irregulares:

- Efeito de bloqueio de vento

- Ondas atmosféricas rio abaixo das montanhas

A parametrização dos fenômenos físicos não compensa completamente as limitações impostas por um espaçamento muito grande da malha dos modelos. A escolha e o ajuste dos esquemas de parametrização têm um impacto significativo na qualidade das previsões.

Cobertura geográfica e intervalo de previsão

Para atender às necessidades imediatas de previsão do tempo, um compromisso aceitável deve ser alcançado para maximizar a resolução espaço-temporal do modelo, levando em consideração:

- o intervalo de previsão desejado (48 horas, dez dias, três meses?)

- o tamanho do domínio geográfico de previsão (país, continente, mundo?)

- prazos de produção e requisitos de confiabilidade

- Recursos de TI, econômicos e humanos disponíveis

Para previsões de curto prazo, o estado da atmosfera em áreas remotas é irrelevante. Um distúrbio atual na América levará alguns dias para se espalhar e fazer sentir sua influência na Europa . Podemos então escolher concentrar uma zona de malha fina do modelo na região de interesse, negligenciando fenômenos distantes. Estamos falando de um modelo regional .

Para previsões de longo prazo, digamos além de dois ou três dias, torna-se necessário aumentar a cobertura do modelo para um hemisfério completo ou mesmo para todo o globo, a fim de lidar adequadamente com os fenômenos ainda distantes que se propagarão. área de interesse. Pelo mesmo motivo, a malha do modelo é distribuída uniformemente pelo globo. Como os modelos hemisféricos caíram em desuso, esse tipo de previsão cai para o modelo global ou modelo global .

Considerações de TIEm teoria, aumentar a resolução do modelo aumenta o realismo e reduz a necessidade de parametrização; no entanto, isso só pode ser feito com custos de TI e econômicos consideráveis, especialmente se a previsão deve ser obtida dentro de prazos apertados.

Exemplo: se a resolução espacial de um determinado modelo é duplicada, o número de pontos na grade de cálculo aumenta por um fator de 8; e se ao mesmo tempo o intervalo de tempo for reduzido pela metade (dobrando assim a resolução temporal), a previsão torna-se 16 vezes mais cara por computador do que a versão anterior do modelo. Para lidar com este problema, não basta multiplicar o poder de computação bruto, pois aspectos de entrada-saída e armazenamento de dados devem ser levados em consideração: o volume de dados a ser transferido durante os cálculos e durante o armazenamento dos resultados também aumenta. pelo mesmo fator. As operações de I / O, que são um gargalo em qualquer tipo de computador, podem se tornar um sério obstáculo para aumentar a resolução dos modelos PNT.

PrevisibilidadeA previsibilidade é o limite da capacidade de prever numericamente os estados futuros da atmosfera usando uma rede de monitoramento fornecida. É geralmente definido pelo período de tempo dentro do qual se espera que a raiz quadrada média do erro de um campo previsto seja menor do que a raiz quadrada média da diferença entre dois estados atmosféricos observados escolhidos aleatoriamente. Na prática, isso resulta na estabilidade da solução da previsão em um tempo X com os dados disponíveis, conhecendo seus erros intrínsecos e sua distribuição espacial, caso uma ligeira variação dos valores seja introduzida nesses dados. O momento em que a solução começa a divergir entre os cálculos das diferentes perturbações torna-se o limite da previsibilidade do sistema meteorológico.

Fontes de erro

- Dados iniciais: erros de medição e análise

- Cobertura de dados: normalmente mais pobre nos oceanos e em áreas escassamente povoadas ou economicamente desfavorecidas

- Erros inerentes aos métodos de cálculo numérico adotados

- Erro causado pela malha do modelo: quanto mais grosseira a malha, menos apto o modelo está para representar fenômenos de média e pequena escala

- Erros de parametrização

Mesmo um modelo perfeito (livre das três últimas fontes de erro) não poderia produzir uma previsão perfeita, pois os erros nas condições iniciais aumentarão durante a previsão e a previsão irá divergir da realidade.

Portanto, é necessário saber com a maior precisão possível o estado inicial da atmosfera. A ciência de determinar esse estado, chamada de assimilação de dados , é em si um grande desafio científico que requer recursos matemáticos e computacionais comparáveis aos dedicados à própria previsão. As fontes de dados são díspares, tradicionalmente compostas de observações de superfície, às quais são adicionados dados de radiossondagem , perfil de vento e medições feitas por aeronaves comerciais. Atualmente, as medições de satélite representam a fonte de dados mais importante e, recentemente, refletividades e velocidades radiais do radar também são levadas em consideração em alguns modelos de mesoescala .

No entanto, o uso de dados de observação por si só não é suficiente. Por um lado, o número de variáveis em um modelo digital é maior do que o número de observações, por outro lado, uma análise realizada diretamente por interpolação das observações levaria a um comportamento instável do modelo. Essa é uma das razões para o fracasso das primeiras tentativas de modelar o comportamento da atmosfera por Richardson .

Para a construção da análise, recorre-se, portanto, a um projecto denominado campo de teste , ou seja, a uma previsão efectuada previamente, geralmente 6 ou 12 horas antes. Este esboço é então corrigido para se ajustar o mais próximo possível às observações, geralmente levando em consideração os erros de observação. A abordagem mais comumente utilizada hoje em dia utiliza os métodos de cálculo das variações para determinar o melhor compromisso entre o calado e as observações, levando em consideração seus respectivos erros. Esta abordagem é designada pelo termo “ 3D-Var ” quando leva em consideração apenas o estado do modelo e as observações válidas no momento da análise, e “ 4D-Var ” quando também leva em consideração a evolução destas ao longo uma janela de tempo.

Previsões de conjunto

Nas primeiras décadas da previsão numérica do tempo, as restrições computacionais exigiam a execução de um modelo na resolução mais alta possível e a adoção da previsão resultante sem modificação. Essa abordagem pressupõe implicitamente que, se as condições iniciais fossem conhecidas perfeitamente e o próprio modelo fosse perfeito, a previsão resultante simularia perfeitamente o comportamento futuro da atmosfera. Chamamos essa abordagem de determinística .

Na prática, nem as observações, nem a análise, nem o modelo são perfeitos. Além disso, a dinâmica atmosférica é muito sensível, sob certas condições, à menor flutuação. Uma nova abordagem probabilística foi, portanto, desenvolvida por pesquisadores como Edward S. Epstein , a da previsão por conjunto . A previsão de conjunto sacrifica a resolução para que possa dedicar recursos de computação à execução de muitas cópias de modelos simultaneamente no mesmo caso de previsão. Em cada caso, a análise é feita deliberadamente ligeiramente diferente dos outros membros do conjunto, dentro das incertezas inerentes de medição ou análise. Os cenários mais ou menos divergentes das previsões oferecidas pelos membros do conjunto permitem quantificar a previsibilidade da atmosfera e oferecer uma margem de erro estatística na previsão. O desafio de projetar tal sistema é garantir que as flutuações observadas nele constituam um sinal representativo da incerteza natural da dinâmica atmosférica.

Alguns sistemas de previsão de ensemble (EPS) também variam os métodos de parametrização dos modelos de membros do ensemble de forma que parte das flutuações nas previsões representem as incertezas da modelagem. Da mesma forma, há um grande interesse na comunidade de pesquisa de predição de conjunto em conjuntos de modelos múltiplos (ou seja, combinar modelos de projetos diferentes) e a agregação de SPE de diferentes países em um superconjunto. Existem atualmente ( 2006 ) dois esforços concretos nessa direção, a saber, o North American Ensemble Prediction System (NAESP) (Canadá, Estados Unidos, México) e o THORPEX Interactive Grand Global Ensemble (TIGGE, sob a coordenação da Organização Meteorológica Mundial ) .

Abordagem operacional

A implementação do NWP para fins de previsão do tempo operacional (em oposição à pesquisa pura) invariavelmente envolve as seguintes etapas, cuja implementação pode diferir um pouco dependendo da localização e das circunstâncias de aplicação:

- Aquisição de dados de observação meteorológica (de estações terrestres, navios, aeronaves, sondas de rádio, dados de satélite de medições remotas, etc.);

- Decodificação e controle de qualidade das observações;

- Análise (desenvolvimento de uma representação digital do estado da atmosfera no início da previsão);

- Lançamento do modelo de previsão com a análise como ponto de partida;

- Pós-processamento das saídas do modelo: produção de imagens, boletins, aplicação de métodos de previsão estatística, interpretação humana;

- Transmissão da previsão aos usuários na forma aplicável ao apoio às diversas atividades (agricultura, transporte, saúde, previsões ambientais, planejamento econômico, etc.);

- Verificação das previsões a posteriori e avaliação do desempenho do modelo.

Exemplo da França

A Météo-France atualmente usa dois modelos digitais, como duas caixas aninhadas uma na outra para emitir seus boletins. O modelo Arpège global (ação de pesquisa em pequena / grande escala) produz previsões para todo o mundo com uma malha esticada com uma resolução horizontal de cerca de 5 km sobre a França continental e cerca de 24 km nos antípodas.

Desde 2008, o modelo Arome (Aplicação da pesquisa às operações em mesoescala) tem feito previsões sobre um domínio limitado, incluindo a França com uma malha de 2,5 km no início, e de 1,3 km desde 2015. O cálculo integra de hora em hora e reajusta as previsões com base sobre informações de estações meteorológicas, navios, bóias, aviões, radar, satélites, etc. O modelo também avalia a confiabilidade da previsão.

Principais centros de aplicação

Embora haja um notável crescimento na aplicação do PNT com meios relativamente modestos, o PNT avançado requer uma infraestrutura de TI considerável que o coloca entre os grandes desafios da computação moderna. A implementação do PNT é geralmente confiada a organizações governamentais ou mesmo supra-governamentais. Os líderes mundiais em PNT são atualmente (em ordem alfabética):

- a Alemanha ( DWD );

- o Canadá ( Centro Meteorológico Canadense );

- o Centro Europeu de Previsão do Tempo de Médio Prazo (consórcio de nações europeias);

- os Estados Unidos ( Centros Nacionais de Previsão Ambiental (civil), Centro de Meteorologia Numérica da Frota e Oceanografia (en) (militar));

- a França ( Météo-France );

- o japonês ( Agência Meteorológica do Japão )

- o Reino Unido (UK Met Office ).

De referir que os grandes operadores dos centros NWP, para além de prestarem serviços de previsão do tempo, também desempenham um papel importante na investigação científica da área. Mais uma vez, as questões de infraestrutura têm a ver com isso: o supercomputador é essencialmente o laboratório do pesquisador do PNT. Além disso, a proximidade de pesquisa e operações ajuda a acelerar a transferência tecnológica de inovações científicas.

Notas e referências

- Katia Chancibault, "Previsão numérica do tempo" (versão de 3 de março de 2016 no Arquivo da Internet ) , Laboratório de Estudos de Transferências em Hidrologia e Meio Ambiente (LTHE)

- (em) Vilhelm Bjerknes, " O problema da previsão do tempo, considerado do ponto de vista da mecânica e da física " , Meteorologische Zeitschrift , Researh Gate flight. 18, n o 6,dezembro de 2009( DOI 10,1127 / 0941-2948 / 2009/416 , lido on-line , acessado 1 st abril 2021 ) "Tradução do artigo original de 1904 para o alemão" .

- Grupo de Trabalho sobre o Uso de Técnicas Modernas em Meteorologia da Aviação, Técnicas de Interpretação para Produtos de Previsão Numérica do Tempo para Meteorologia da Aviação , Vol. 195, Organização Meteorológica Mundial , col. "Notas Técnicas",1994, 112 p. ( leia online ) , cap. 1.1 ("História da previsão numérica do tempo").

- (em) Kristine Harper , Louis W. Uccellini , Eugenia Kalnay Kenneth Carey e Lauren Morone , " 2007: 50th Anniversary of Operational Numerical Weather Prediction " , Bulletin of the American Meteorological Society , vol. 88, n o 5,Maio de 2007, p. 639-650 ( DOI 10.1175 / BAMS-88-5-639 , Bibcode 2007BAMS ... 88..639H ).

- MALARDEL Sylvie, " Modelos de previsão do tempo " , na Enciclopédia do meio ambiente ,2019(acessado em 26 de novembro de 2019 )

- World Meteorological Organization , " Predictability " , Meteorological Glossary on Eumetcal (acessado em 30 de novembro de 2013 )

- Hélène Côté, “ Quais são reanálises? » , Perguntas frequentes , Consórcio sobre Climatologia Regional e Adaptação às Mudanças Climáticas (Ouranos) (acessado em 14 de setembro de 2015 )

- (em) Peter Lynch Met Éiriann, " Previsão de Richardson: O que deu errado? " [PDF] , NOAA,Junho de 2004 - Uma análise do primeiro ensaio de previsão de Richardson.

- Azar Khalatbari , " Uma centena de vezes mais preciso do tempo ", Sciences et Avenir , n o 725,Julho de 2007( leia online ).

Veja também

Bibliografia

- Sylvie Malardel, Fundamentos de Meteorologia - 2 nd edição: Na escola de tempo , Toulouse, Cépaduès,2009, 711 p. ( ISBN 978-2-85428-851-3 )

- (pt) Hagos S e LR Leung, “ Variáveis Ambientais de Grande Escala e Transição para Convecção Profunda em Simulações de Modelos de Resolução de Nuvens: Uma Representação de Vetores ” , Journal of Advances in Modeling Earth Systems , vol. 4, n o M11001,2012( DOI 10.1029 / 2012MS000155 )

Artigos relacionados

- Equações atmosféricas primitivas

- Número da corrente

- Climateprediction.net

- Lewis fry richardson

- Odon Godart

- André Robert

- Previsão quantitativa de precipitação

- Formato GRIB para disseminação de dados modelo

links externos

- Canadian Meteorological Centre , “ Explanation of the TFN, ” Government of Canada .

- "Previsão numérica do tempo" (versão de 3 de março de 2016 no Internet Archive ) , Euromet.

- " Previsão do tempo " , Météo France .

- “ O sistema de previsão COSMO ” , MeteoSwiss .

- (pt) Wilhelm Bjerknes, "O problema da previsão do tempo, visto dos pontos de vista da Mecânica e da Física" (versão de 14 de junho de 2020 no Internet Archive ) , NOAA .

- Katia Chancibault, " Previsão numérica do tempo " [ arquivo du3 de março de 2016] [PDF] , Riscos hidrometeorológicos, inundações e inundações , Laboratório de Estudos de Transferências em Hidrologia e Meio Ambiente (LTHE) (consultado em 31 de março de 2021 ) .

- (fr) Peter Lynch, Met Éireann , “ Previsão de Richardson: O que deu errado? (Uma análise do primeiro teste de previsão de Richardson) ” [PDF] , National Oceanic and Atmospheric Administration (NOAA),Junho de 2004(acedida em 1 r abril 2021 ) .